こんにちは.高山です.

少し時間が経ってしまいましたが,KaggleのGoogle Isolated Sign Language Recognitionというコンテストに参加していました.

Kaggle自体が初めてで中々思ったような結果が出せず,最終順位は283/1165位でしたが色々と勉強になりました.

更新履歴 (大きな変更のみ記載しています)

- 2024/09/17: タイトル,タグ,節構成を更新しました

コンテストの紹介

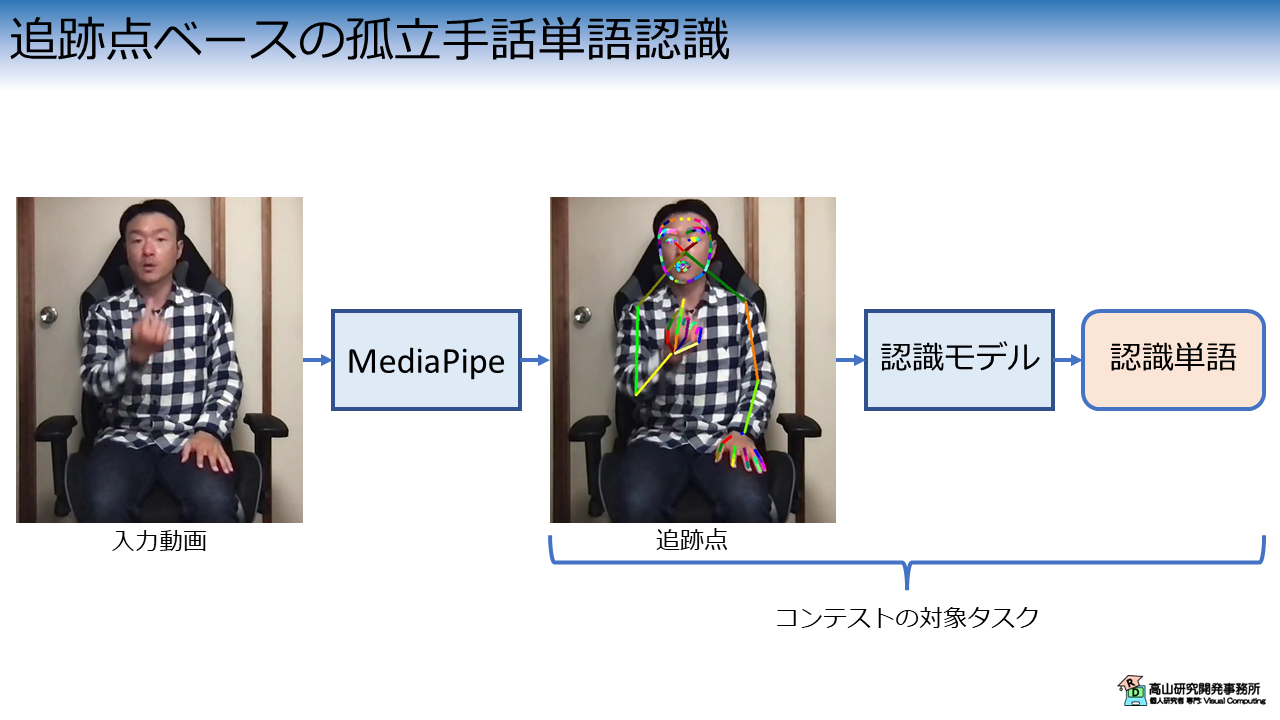

このコンテストでは図1に示すように,手話動画から孤立単語を認識して精度を競い合います.

骨格追跡点ベースの孤立手話単語認識では,最初に手話動画から骨格追跡点を抽出して,その後認識モデルを用いて手話単語を出力します.

今回のコンテストでは,MediaPipe [MediaPipe'23]で抽出した骨格追跡点データが,学習およびテスト用として提供されます (生動画は与えられない).

参加者は提供データを用いて,各自で認識モデルを作成して精度を競い合います.

オーソドックスなタスクですが,下記のような特徴があります.

- 対象はアメリカ手話

- 提出モデルはTensorflow Liteの形式でなければならない

- テスト時の平均推論時間は100msec以内でなければならない

スポンサーはモバイルアプリの開発に繋げたいようで,そこを意識した制約が盛り込まれています.

手話認識の個人研究者としては,データが商用利用可の条件で公開されたのは大きいです.

手話認識の研究は人材および研究データ不足が長年の課題になっていますが,生の手話動画データは個人情報が満載でセンシティブな取り扱いが必要です.

手話動画データベースは非公開であったり,学術機関しか利用できなかったりと制約が厳しい場合が多く,一般の開発者は手を出すことが難しい状況が続いていました.

動画ではなく骨格追跡点で,かつ,量もそこまで多くはないですが,このようなデータベースをきっかけに,手話認識の研究開発も盛り上がってくれると良いですね.

Googleが手話関連の研究を行っている (例えば[Moryossef'20]) ことは以前から知っていましたが,続報がなかったので休眠状態なのかと思っていました.

今は (2023年6月現在) 指文字のコンテスト も主催しているようで,今後さらなる動きがあるのか楽しみですね.

このコンテストとデータベースは色々と面白そうなので,またどこかのタイミングで記事を出せればと思っています.